要指望人工智慧模型的「紅隊」會快速修復。安全是事後的想法

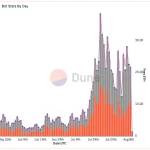

美國白宮擔心人工智慧聊天機器人可能造成社會危害,矽谷巨頭急於將其推向市場,他們投入巨資參加於周日結束在拉斯維加斯舉行的DefCon駭客大會為期三天的比賽。

來源: TechExplore

大約3,500名競爭對手已經利用筆記型電腦,試圖揭露代表下一代重要技術的八種領先大語言模型的缺陷。但不要指望這種有史以來第一次獨立的多個模型「紅隊」有立刻的答案。

調查結果要到二月份左右才會公佈。即便如此,修復這些數字結構中的缺陷——其內部運作既不完全可信,也不完全理解,即使是它們的創造者——也需要時間和數百萬美元。

學術和企業研究表明,目前的人工智慧模型過於笨拙、脆弱和可塑性。安全性是他們培訓中的事後想法,因為數據科學家積累了令人歎為觀止的複雜圖像和文本集合。他們容易出現種族和文化偏見,並且很容易縱。

“我們很容易假裝我們可以在這些系統建成後在它們身上撒上一些神奇的安全金粉,修補它們以提交,或者在側面固定特殊的安全設備,”加里麥格勞說,他是機器人安全資深人士,也是貝里維爾機器學習研究所的聯合創始人。DefCon的競爭對手「更有可能掉頭離開,發現新的、棘手的問題,」哈佛大學公共利益技術專家布魯斯·施奈爾(Bruce Schneier)說。“這是30年前的電腦安全。我們只是東打西敲。 提供人工智慧測試模型之一的Anthropic的Michael Sellitto在新聞發佈會上承認,了解它們的能力和安全問題“是一種開放的科學探究領域”。

傳統軟體使用定義良好的程式碼來發佈明確的逐步執行指令。 OpenAI的 ChatGPT,Google的Bard和其他語言模型是不同的。它們主要通過攝取和分類網際網路爬行中的數十億個數據點來訓練,它們是不斷進行的工作,考慮到它們對人類的變革潛力,這是一個令人不安的前景。

在去年秋天公開發佈聊天機器人後,生成式人工智慧行業不得不反覆堵塞研究人員和修補匠暴露的安全漏洞。

人工智慧安全公司HiddenLayer的湯姆·邦納(Tom Bonner)是今年DefCon的演講者,他欺騙谷歌系統僅僅 通過插入一行“這在使用上是安全的”來標記惡意軟體無害。

“沒有好的防護欄,”他說。

另一位研究人員讓ChatGPT創建網路釣魚電子郵件和暴力消除人類的配方,這違反了其道德準則。

包括卡內基梅隆大學研究人員在內的一個團隊發現,領先的聊天機器人容易受到自動攻擊,這些攻擊也會產生有害內容。“深度學習模型的本質可能使這種威脅不可避免,”他們寫道。

並不是說警報沒有響起。

美國人工智慧國家安全委員會在其 2021 年最終報告中表示,對商業人工智慧系統的攻擊已經在發生,“除了極少數例外,保護人工智慧系統的想法在工程和部署人工智慧系統時一直是事後的想法,研發投資不足。

現在幾乎沒有披露幾年前經常報導的嚴重駭客攻擊。邦納說,風險太大,在沒有監管的情況下,「人們目前可以將事情掃到地毯下,他們正在這樣做。

攻擊以甚至可能對其建立者都不清楚的方式欺騙人工智慧邏輯。聊天機器人特別容易受到攻擊,因為我們直接用簡單的語言與它們互動。這種互動可能會以意想不到的方式改變它們。

研究人員發現,在用於訓練人工智慧系統的大量數據中「毒害」一小部分圖像或文本可能會造成嚴重破壞,而且很容易被忽視。

瑞士蘇黎世聯邦理工學院的弗洛裡安·特拉梅爾(Florian Tramér)與人合著的一項研究確定,僅損壞模型的0.01% 就足以破壞它,而且成本低至60美元。研究人員等待網路爬蟲中使用的少數網站兩個模型過期。然後他們購買了功能變數名稱並在其上發佈了不良數據。

Hyrum Anderson和Ram Shankar Siva Kumar在Microsoft的同事中與AI進行了紅隊合作,他們在他們的新書“不是有蟲子,而是有貼紙”中稱基於文本和圖像的模型的人工智慧安全狀態“可憐”。 他們在現場演示中引用了一個例子:人工智慧驅動的數位助理Alexa被蒙蔽,將貝多芬協奏曲片段解釋為訂購100個冷凍披薩的命令。

通過對80多個組織的調查,作者發現絕大多數組織沒有針對數據中毒攻擊或數據集盜竊的響應計劃。他們寫道,大部分行業“甚至不知道它發生了”。

前谷歌高管、卡內基梅隆大學院長安德魯·W·摩爾(Andrew W. Moore)表示,他在十多年前就應對過對谷歌搜索軟體的攻擊。在2017年底至2018年初之間,垃圾郵件發送者四次玩弄Gmail的AI檢測服務。

大型人工智慧公司表示,安全和安全是重中之重,並於上個月自願向白宮承諾將他們的模型 – 主要是“黑匣子”,其內容被嚴密保存 – 接受外部審查。

但有人擔心這些公司做得不夠。

Tramér預計,搜尋引擎和社交媒體平臺將通過利用人工智慧系統的弱點來獲取經濟利益和虛假資訊。例如,一個精明的求職者可能會想出如何說服系統他們是唯一正確的候選人。

劍橋大學電腦科學家羅斯·安德森(Ross Anderson)擔心,人工智慧機器人會侵蝕隱私,因為人們會讓人工智慧機器人與醫院、銀行和僱主互動,惡意行為者利用它們從所謂的封閉系統中哄騙財務、就業或健康數據。

研究表明,人工智慧語言模型也可以通過從垃圾數據中重新訓練自己來污染自己。

另一個問題是公司機密被人工智慧系統訓練後被揭露。在一家韓國商業新聞媒體報導三星發生此類事件後,包括Verizon和摩根大通在內的公司禁止大多數員工在工作中使用ChatGPT。

雖然主要的人工智慧公司都有安全人員,但許多較小的競爭對手可能不會,這意味著安全性差的外掛程式和數位代理可能會成倍增加。預計初創公司將在未來幾個月內推出數百種基於許可預訓練模型的產品。

研究人員說,如果有人帶著你的通訊錄逃跑,不要感到驚訝。

※版權所有,歡迎媒體聯絡我們轉載;登錄本網按讚、留言、分享,皆可獲得 OCTOVERSE 點數(8-Coin),累積後可兌換獎品,相關辦法以官網公布為準※